vSphere 8.0 U2 で、vSphere with Tanzu の自宅ラボ環境を構築していきます。今回は、3-Zone スーパーバイザーを構築してみます。

この手順の直前にあたる投稿はこちら。

今回の内容です。

ドキュメントでは、下記のあたりが参考になります。

ラボ構成のイメージ

今回の環境は、まだワークロード管理が有効化されていない(もしくは 無効化 してある)状態を想定しています。

3-Zone スーパーバイザーを構築することで、制御プレーン仮想マシンが、vSphere Zone ごとに 1台(3-Zone なので合計 3台)展開されます。

今回の環境

これまでの投稿での「Part-09: Tier-0 ゲートウェイの作成」までの手順を実施してある環境で、さらにここで説明するように、クラスタの ESXi 配置とデータストア接続を変更しておきます。

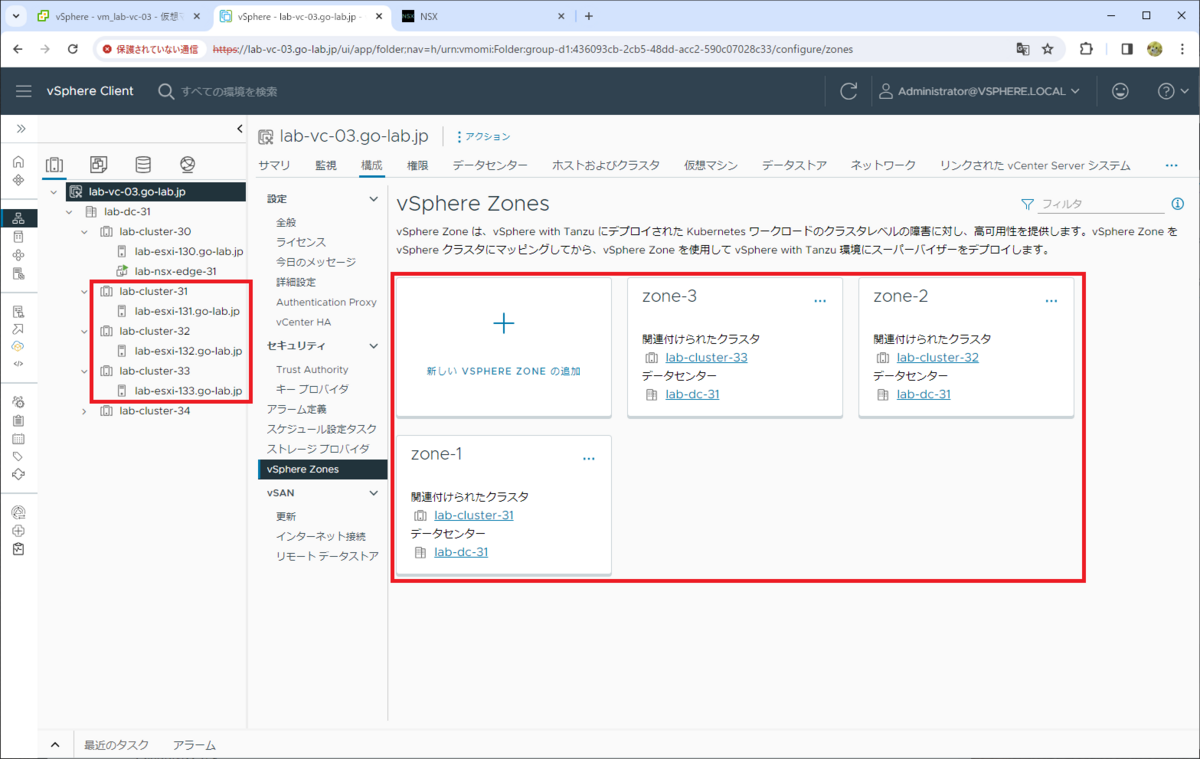

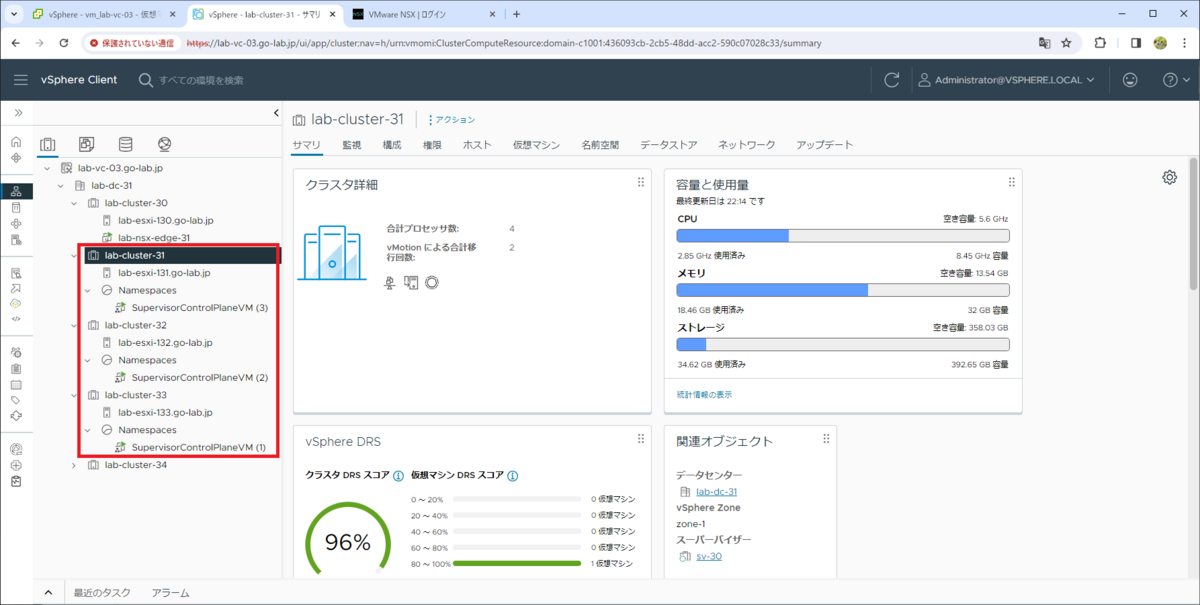

vSphere クラスタと ESXi ホストの配置

今回は 3つのクラスタに、それぞれ 1台の ESXi ホストを配置しています。ワークロード管理を有効化する3つのクラスタでは、配下の ESXi ホストのメンテナンス モードを解除しておきます。

- lab-cluster-31 クラスタ → ESXi ホスト lab-esxi-131.go-lab.jp のみ配置

- lab-cluster-32 クラスタ → ESXi ホスト lab-esxi-132.go-lab.jp のみ配置

- lab-cluster-33 クラスタ → ESXi ホスト lab-esxi-133.go-lab.jp のみ配置

そして、それぞれのクラスタで vSphere Zone(zone-1、zone-2、zone-3)を作成ずみです。

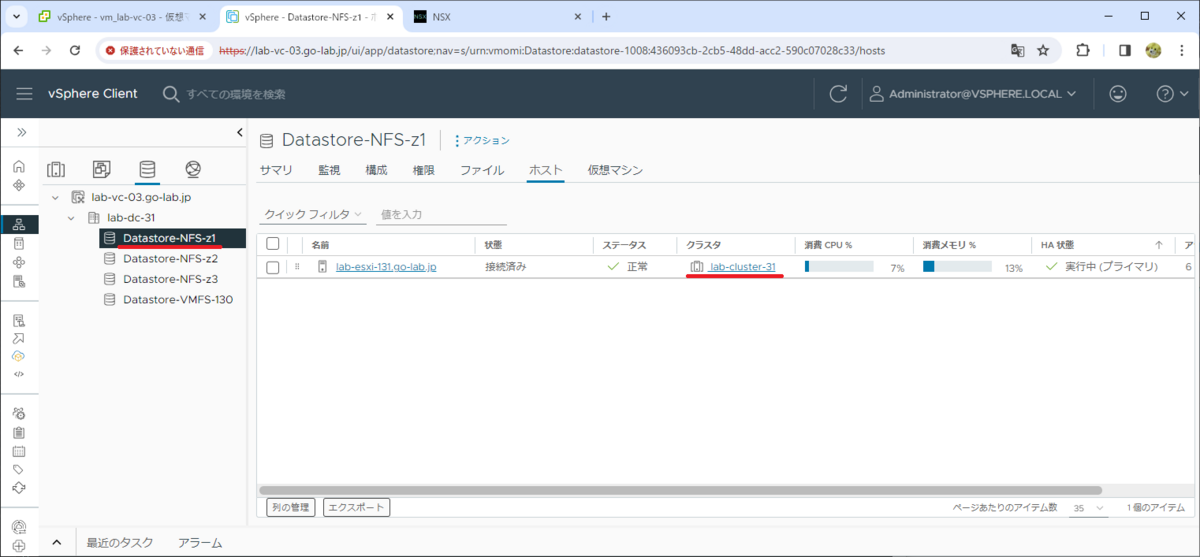

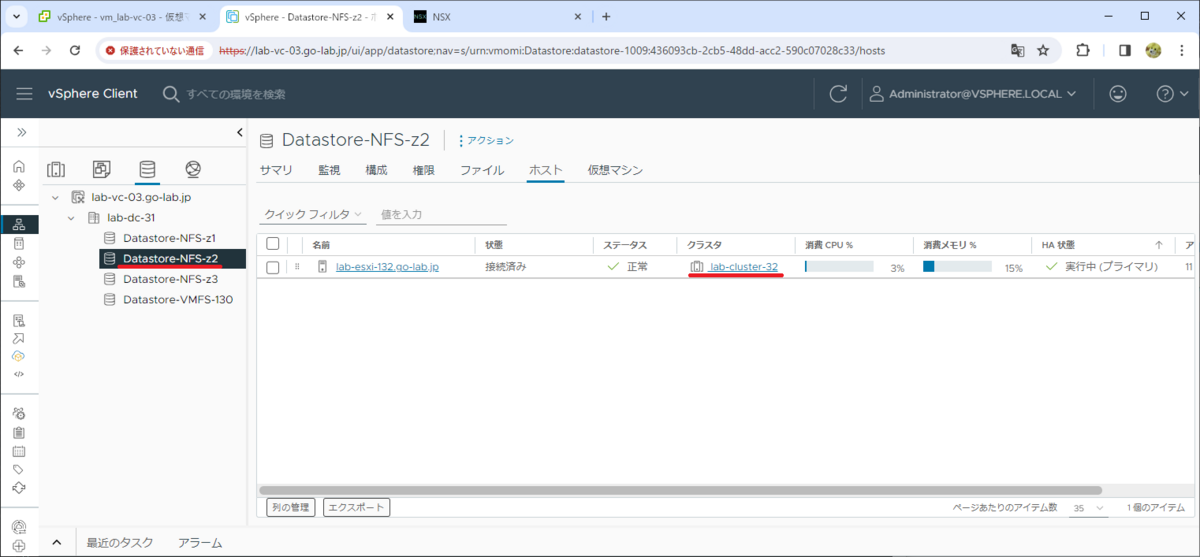

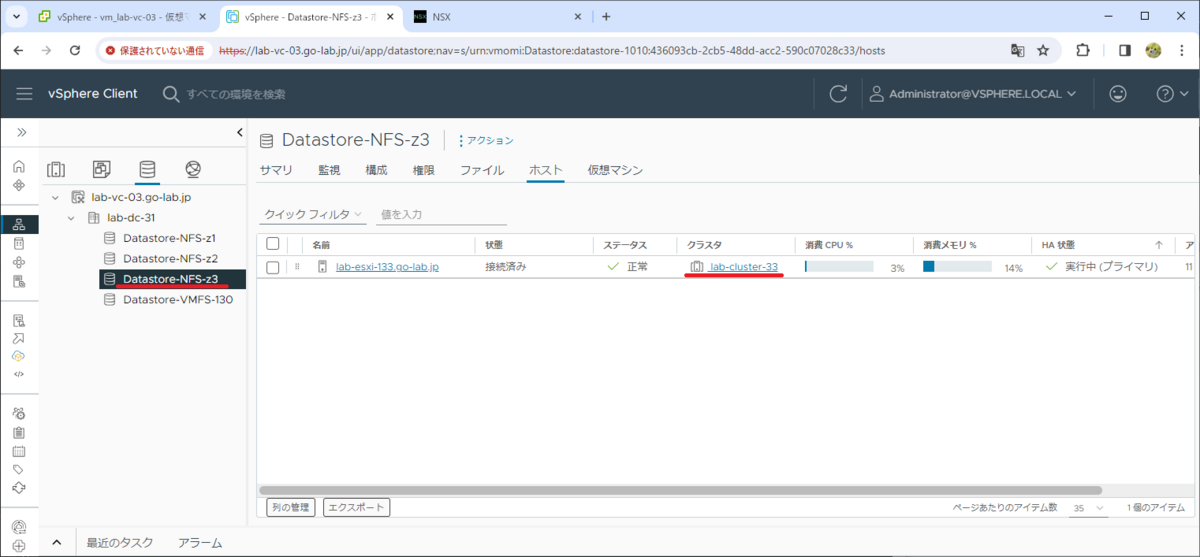

共有データストアと ESXi ホストの接続変更

各クラスタの ESXi ホストでは、それぞれ独立した共有データストアをマウントしておきます。

Datastore-NFS-z1 → lab-cluster-31 の ESXi ホストのみがマウント

Datastore-NFS-z2 → lab-cluster-32 の ESXi ホストのみがマウント

Datastore-NFS-z3 → lab-cluster-33 の ESXi ホストのみがマウント

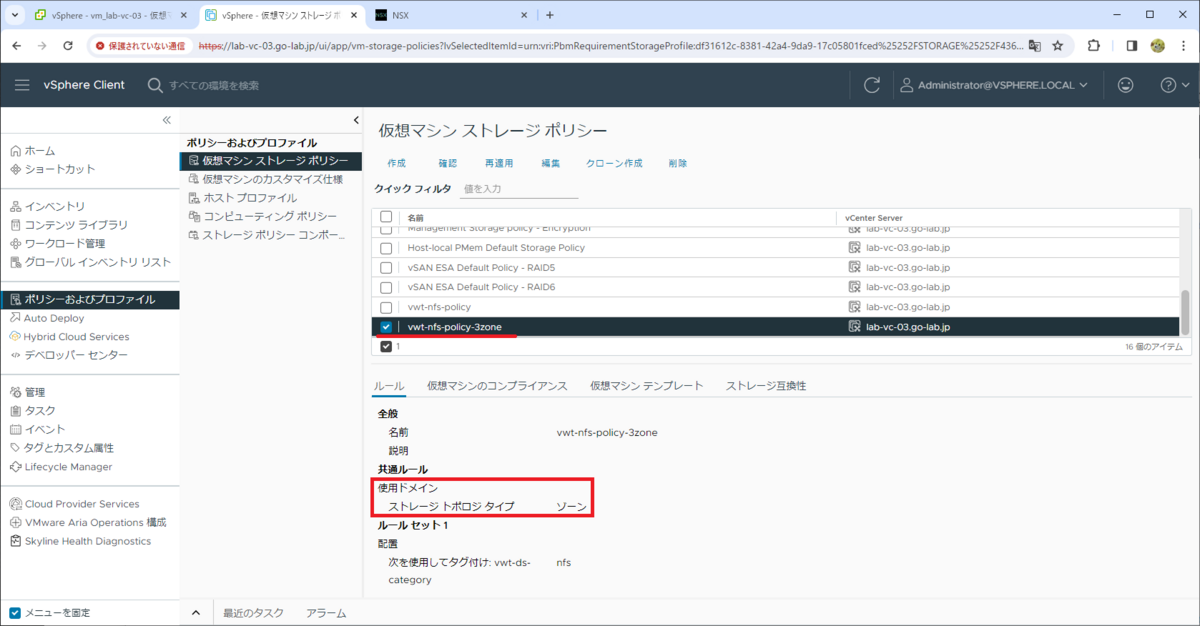

仮想マシン ストレージ ポリシー

3-Zone に対応した仮想マシン ストレージ ポリシーは「Part-04: ストレージ ポリシーの作成 」で作成ずみのものを利用します。

- 仮想マシン ストレージ ポリシー: vwt-nfs-policy-3zone

ワークロード管理の有効化(スーパーバイザーの構築)

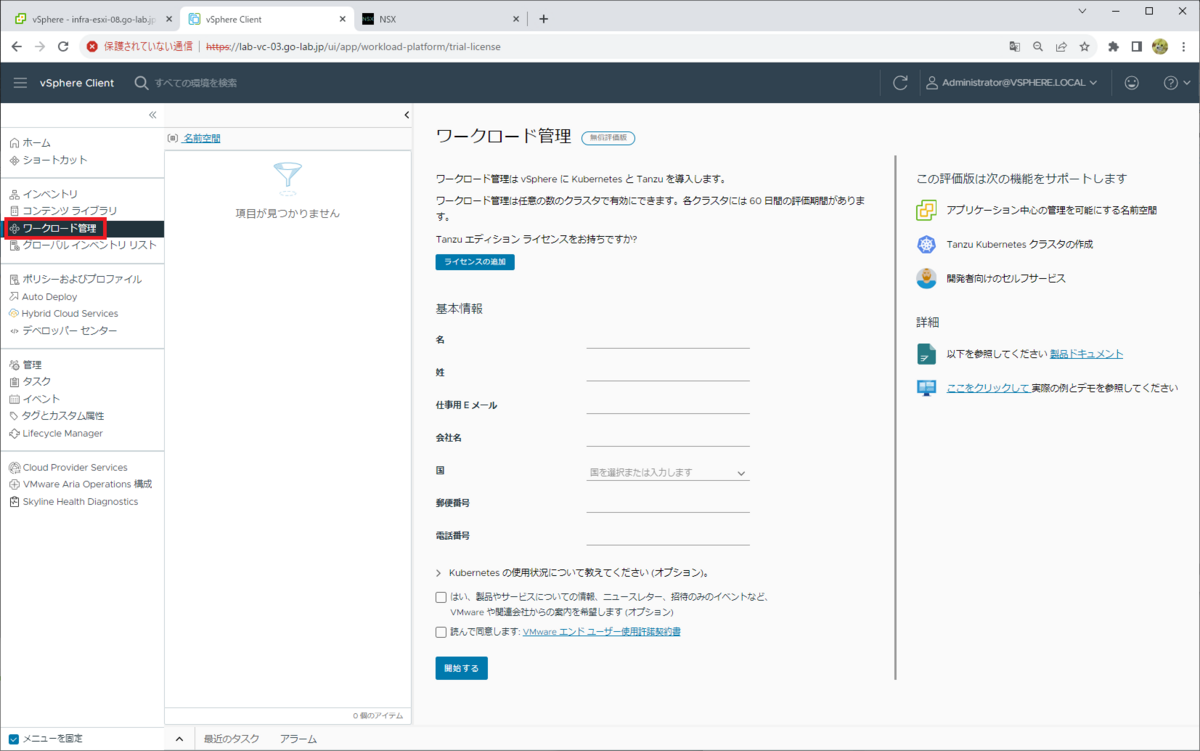

ここからは、「ワークロード管理」メニューを開いて作業します。

初回のみ、評価モードで(ライセンス キーを入力しないで)利用するには評価者の情報を入力する必要があります。

この時点では、ワークロード管理は無効化してあります。

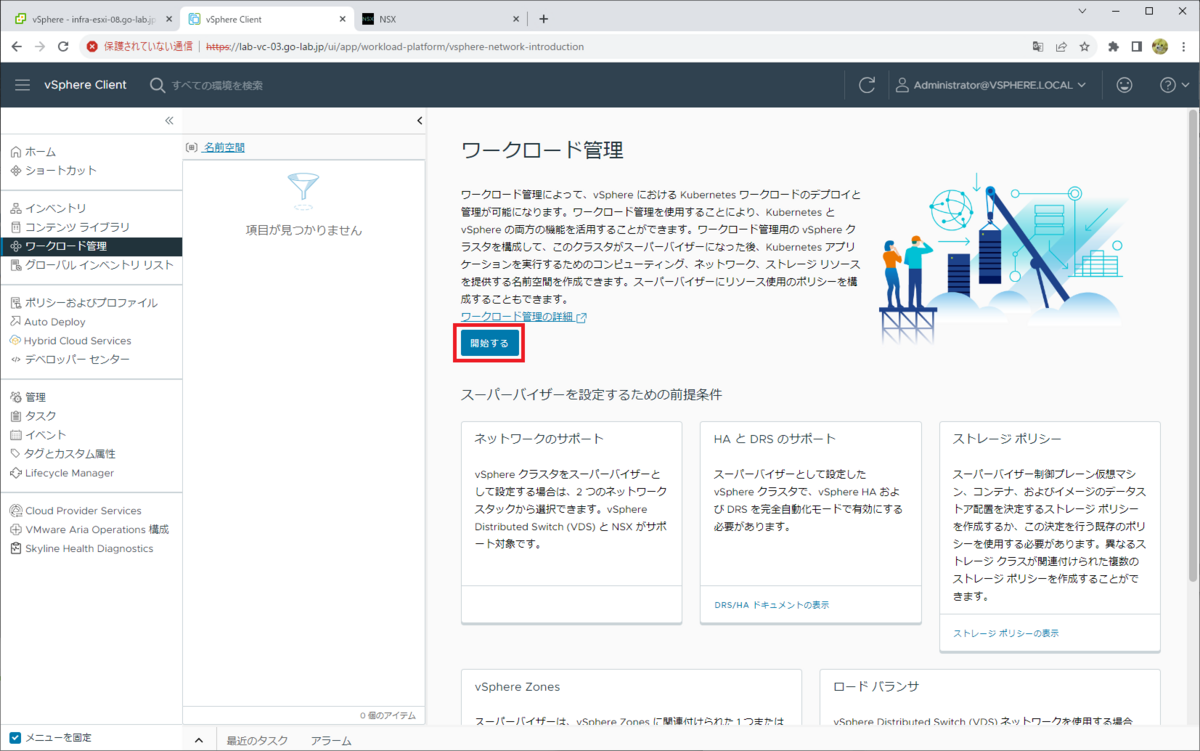

「開始する」をクリックします。

1. vCenter Server とネットワーク

ネットワーク スタックを選択して、「次へ」をクリックします。

- ネットワーク スタックの選択: NSX

2. スーパーバイザーの配置

今回は 3-Zone 構成なので、「VSPHERE ZONE のデプロイ」タブを選択します。

スーパーバイザーの名前と、ワークロード管理を有効化する(スーパーバイザーにする)クラスタを指定します。今回は 事前に vSphere Zone を作成してありますが、未作成の場合は、この画面で作成できます。

- スーパーバイザー名: sv-30

- クラスタ名: lab-cluster-31

- vSphere Zone 名: zone-1、zone-2、zone-3

3. ストレージ

Supervisor Control Plane VM のデータストア配置を指定するための仮想マシン ストレージ ポリシーを選択して、「次へ」をクリックします。

- 制御プレーン ストレージ ポリシー: vwt-nfs-policy-3zone

- 短期ディスク ストレージ ポリシー: 選択不可

- イメージ キャッシュ ストレージ ポリシー: 選択不可

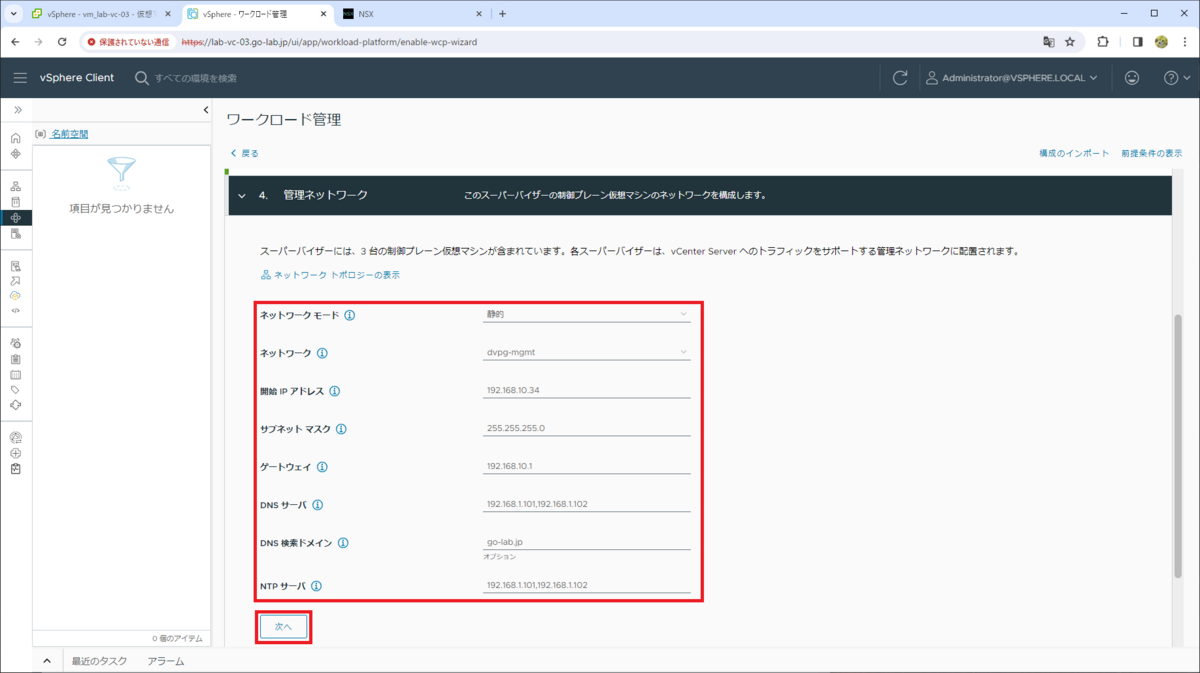

4. 管理ネットワーク

Supervisor Control Plane VM(3台)の管理ネットワークを設定して、「次へ」をクリックします。このラボでは、下記のように設定しています。

- ネットワーク モード: 静的

- ネットワーク: dvpg-mgmt

- 開始 IP アドレス: 192.168.10.34(5つの IP アドレスが予約されるので ~ .38)

- サブネット マスク: 255.255.255.0

- ゲートウェイ: 192.168.10.1

- DNS サーバ: 192.168.1.101, 192.168.1.102

- DNS 検索ドメイン: go-lab.jp

- NTP サーバ: 192.168.1.101, 192.168.1.102

5. ワークロード ネットワーク

スーパーバイザーの Kubernetes クラスタとしてのネットワーク設定です。このラボでは、下記のパラメータを入力して「次へ」をクリックします。

- vSphere Distributed Switch: DSwitch-31

- DNS サーバ: 192.168.1.101,192.168.1.102

- Edge クラスタ: edge-cluster-31

- Tier-0 ゲートウェイ: t0-gw-31

- NAT モード: 有効 ※デフォルトのまま

- サブネット プリフィックス: /28 ※デフォルトのまま

- 名前空間ネットワーク: 10.244.0.0/20 ※デフォルトのまま

- 入力方向 CIDR: 192.168.131.32/27

- 出力方向 CIDR: 192.168.131.64/27

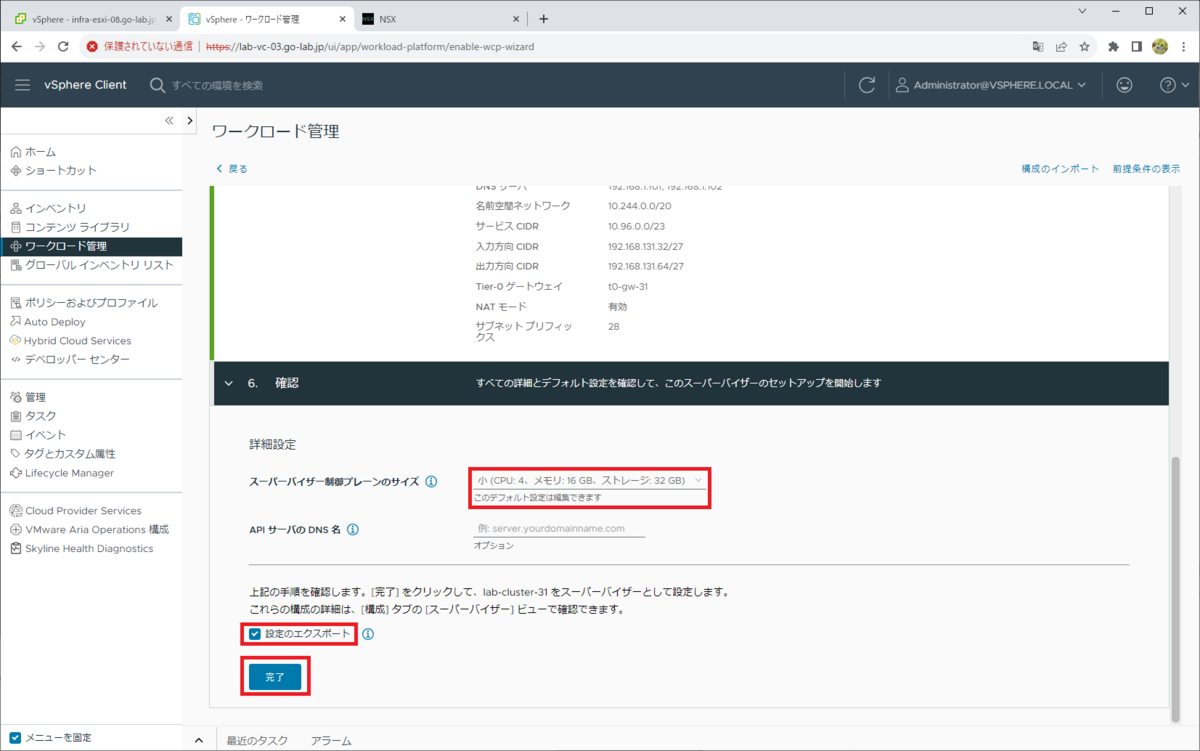

6. 確認

画面のタイトルは「6. 確認」となっていますが、Supervisor Control Plane VM のサイズなどを指定します。

- スーパーバイザー制御プレーンのサイズ: 小(4 vCPU、16GB RAM、32GB ストレージ)

- API サーバの DNS 名: 空欄のまま

- 設定のエクスポート: ON

そして「完了」をクリックすると、ワークロード管理を有効化する処理が開始します。

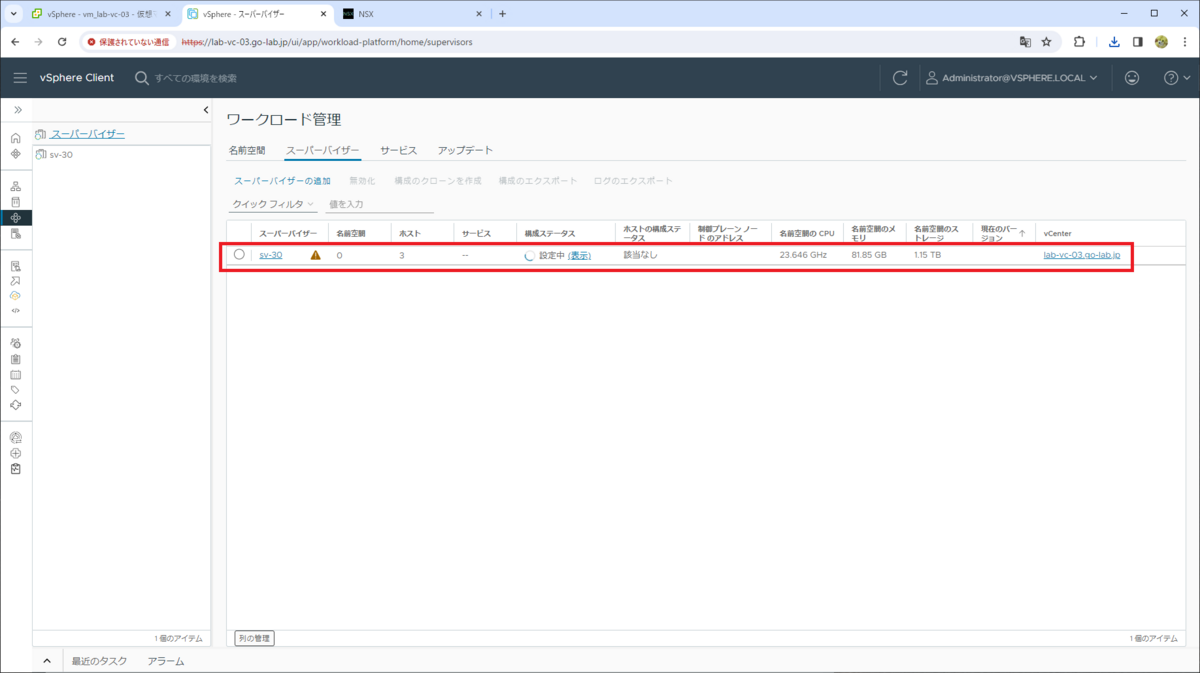

しばらく待ちます。

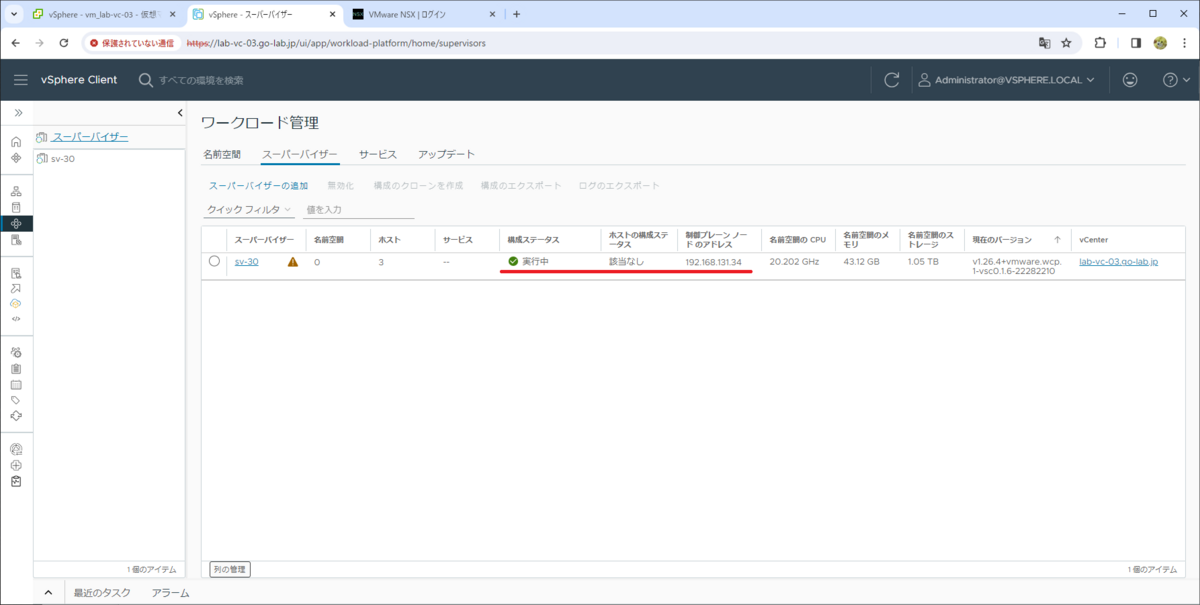

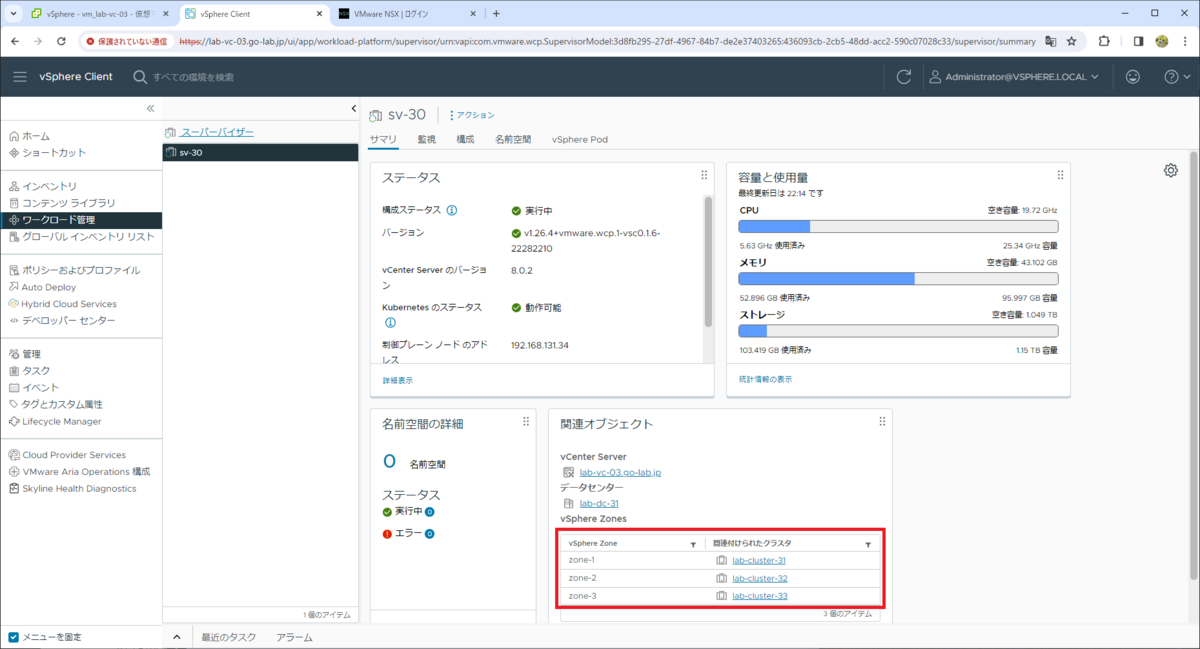

処理が完了すると、「構成ステータス」が「実行中」になり、「制御プレーン ノードの IP アドレス」が入力方向 CIDR のレンジの IP アドレスから設定されます。

ちなみに、3-Zone スーパーバイザーでは、ネットワーク スタックで NSX を利用していても ESXi ホストがワーカーとして構成されず、vSphere Pod も起動できません。この画面の「ホストの構成ステータス」も「該当なし」となっています。

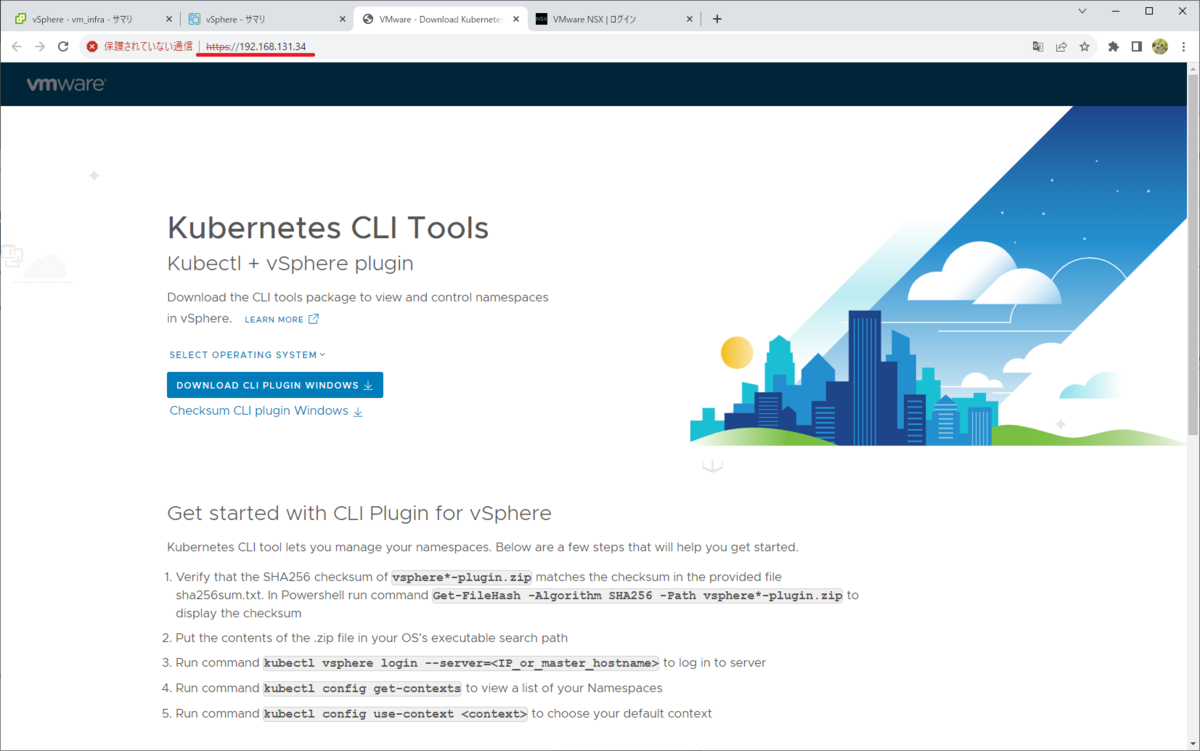

制御プレーン ノードの IP アドレスに Web ブラウザでアクセスして、証明書エラーを無視して進むと、Kubernetes CLI Tools のダウンロード ページが表示されます。

ワークロード管理が有効化されたクラスタの様子

ワークロード管理が有効化され、スーパーバイザーが組み込まれた 3つのクラスタには、それぞれ「Namespaces」リソースプールが作成されます。そして、Supervisor Control Plane VM が 1台ずつ(合計で 3台)展開されます。

ちなみに、クラスタに複数台の ESXi ホストが配置されていたとしても、Supervisor Control Plane VM は 3台ではなく 1台のみデプロイされます。

各クラスタの「サマリ」タブには、同じスーパーバイザー(sv-30)へのリンクが表示されます。

「ワークロード管理」メニューで、スーパーバイザー「sv-30」の「サマリ」タブを確認すると、3つの vSphere Zone(zone-1、zone-2、zone-3)で構成されていることが分かります。

つづく。