vSphere 8.0 U2 で、vSphere with Tanzu の自宅ラボ環境を構築していきます。今回は、ワークロード管理を有効化して、スーパーバイザーを構築します。

今回の内容です。

ドキュメントでは、下記のあたりが参考になります。

ラボ構成のイメージ

今回は、ワークロード管理を有効化して、1-Zone のスーパーバイザーを構築します。制御プレーン 仮想マシン(Supervisor Control Plane VM)が3台が自動展開され、vSphere に Kubernetes の機能が組み込まれます。

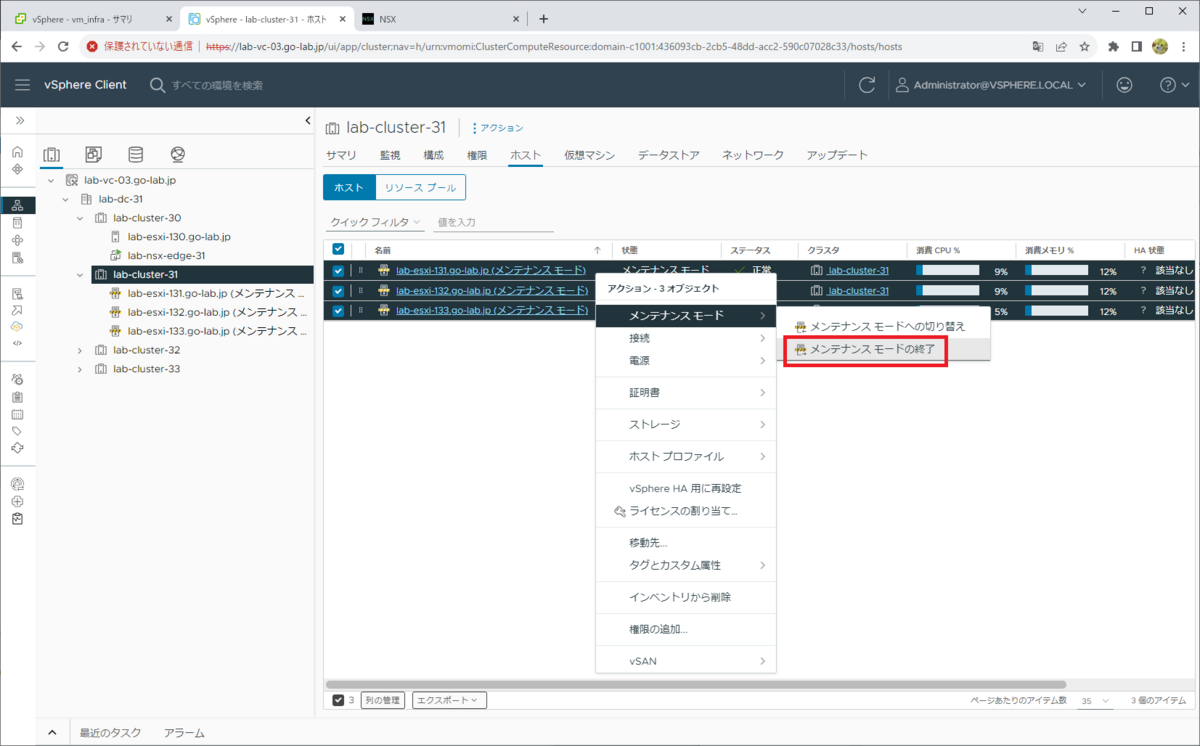

ESXi ホストのメンテナンス モード解除

ワークロード管理を有効化するクラスタで、配下の ESXi ホストのメンテナンス モードを解除しておきます。

クラスタの「ホスト」タブで ESXi ホストをすべて選択して、右クリック →「メンテナンス モード」→「メンテナンス モードの終了」をクリックします。

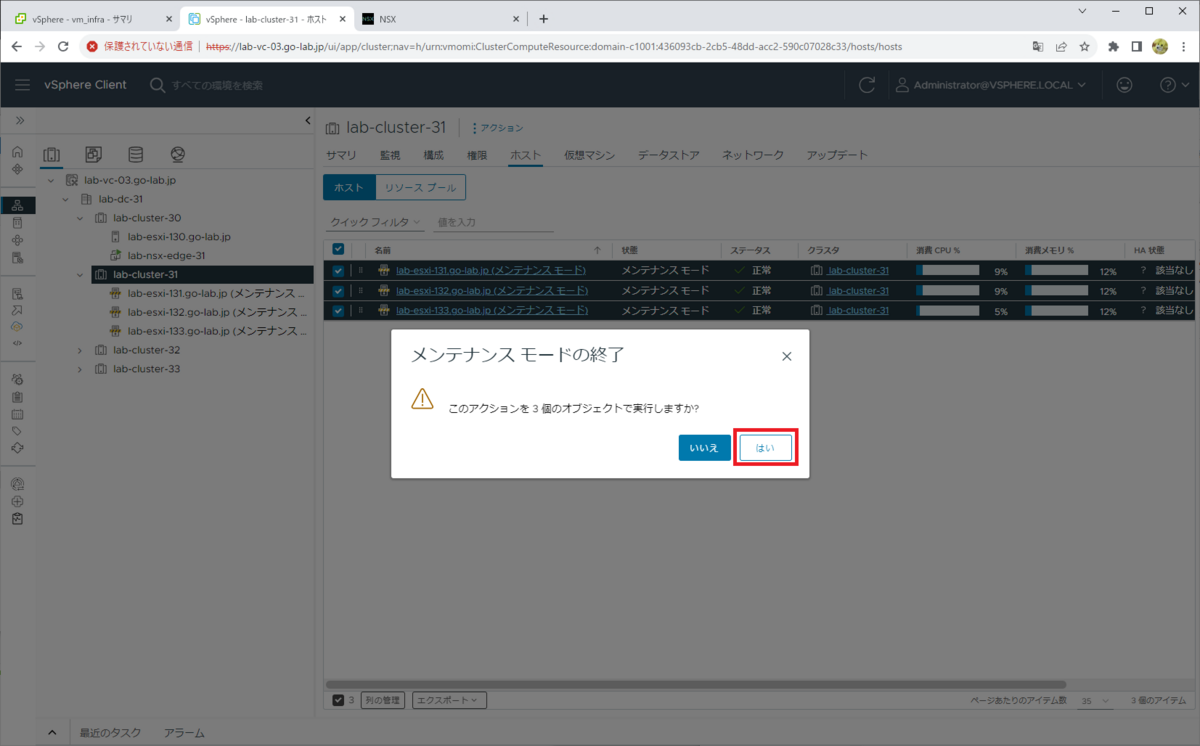

確認メッセージが表示されるので、「はい」をクリックします。

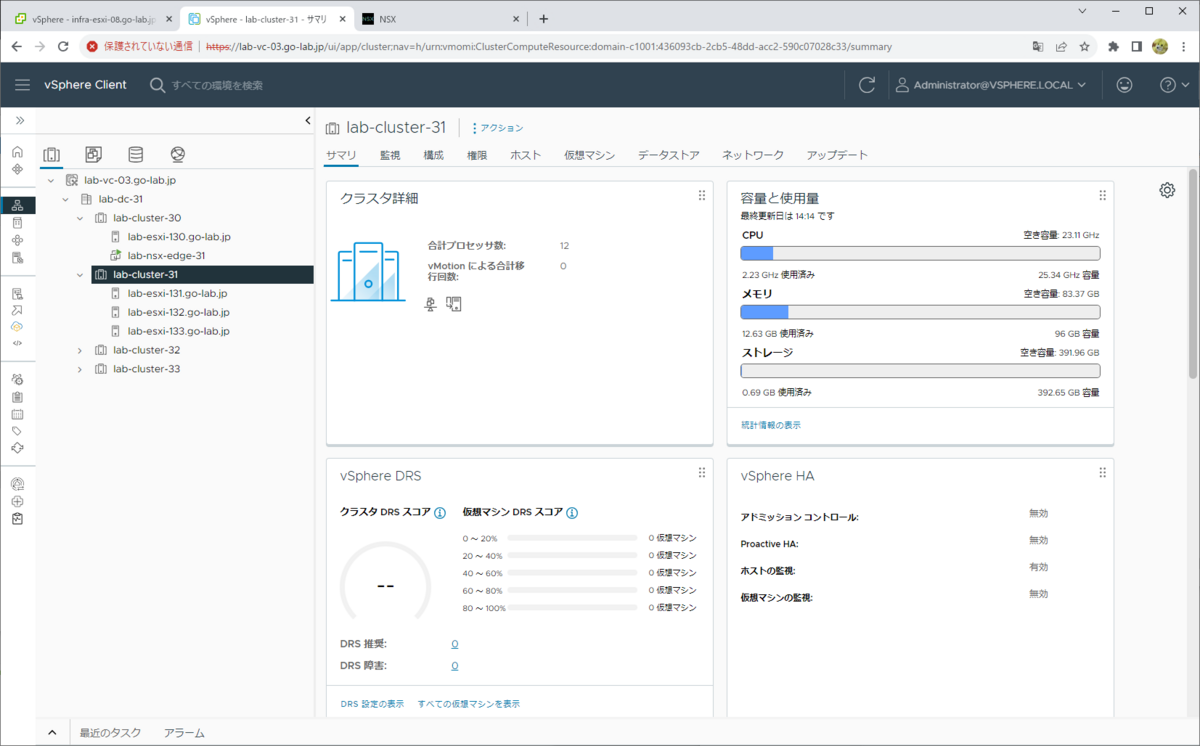

ワークロード管理を有効化する前のクラスタでの、リソースの様子です。

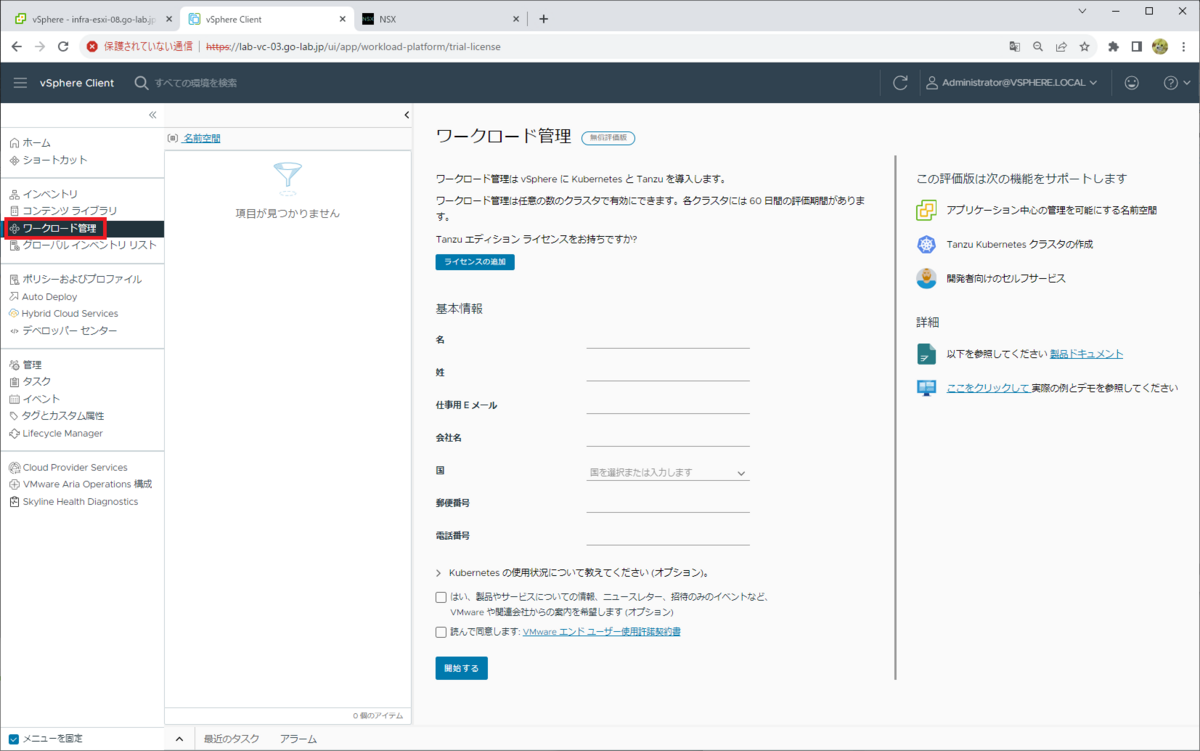

ワークロード管理の有効化(スーパーバイザーの構築)

vSphere Client で「ワークロード管理」を有効化すると、スーパーバイザーが構築されます。

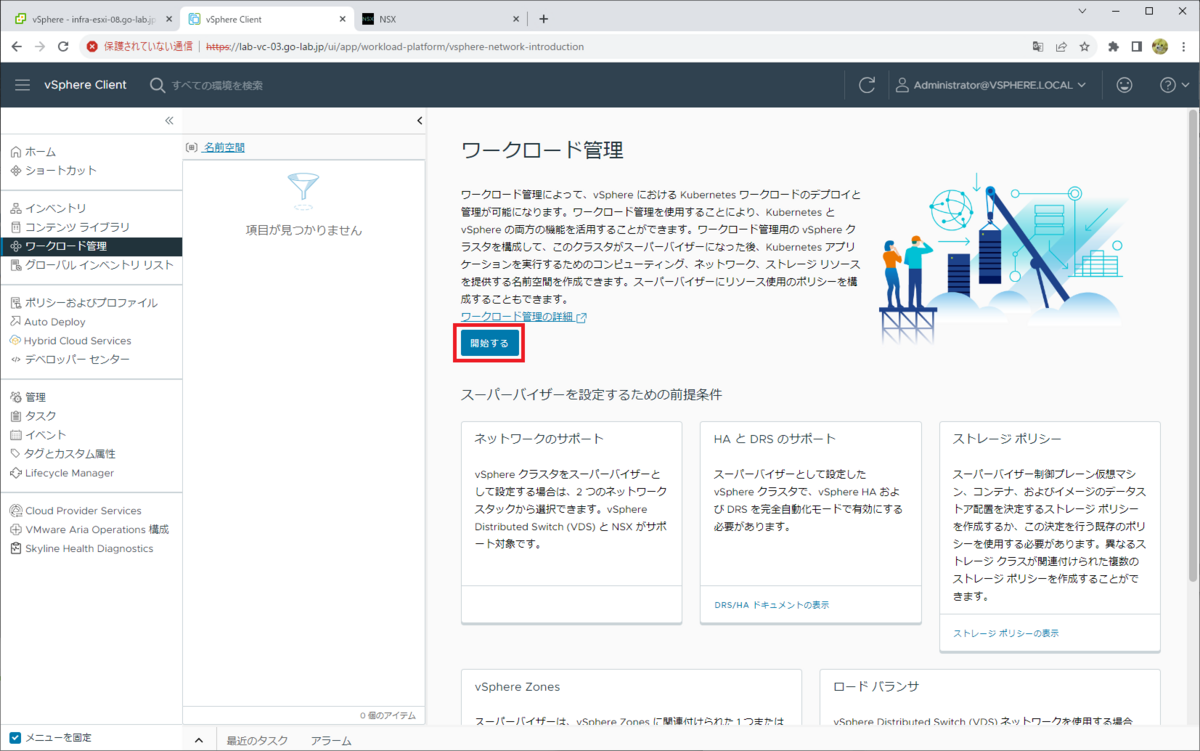

「ワークロード管理」メニューを開きます。

評価モードで(ライセンス キーを入力しないで)利用するには、初回のみ利用者の情報を入力する必要があります。

「開始する」をクリックします。

1. vCenter Server とネットワーク

ネットワーク スタックを選択して、「次へ」をクリックします。

- ネットワーク スタックの選択: NSX

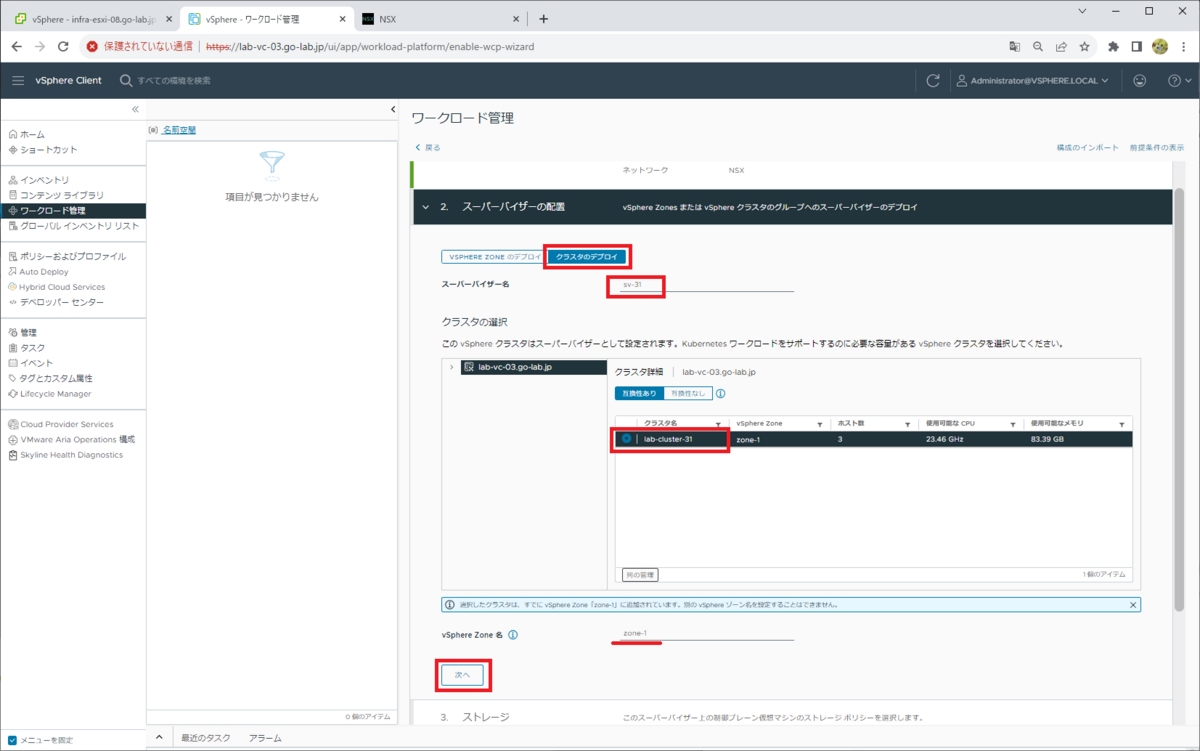

2. スーパーバイザーの配置

今回は 1-Zone 構成なので、「クラスタのデプロイ」タブを選択します。

スーパーバイザーの名前と、ワークロード管理を有効化する(スーパーバイザーにする)クラスタを指定します。vSphere 7 のころはスーパーバイザーはクラスタと同名となっていましたが、vSphere 8 からは独立した名前を指定できるようになりました。

今回は 事前に vSphere Zone を作成してありますが、未作成の場合は、この画面で作成できます。

- スーパーバイザー名: sv-31

- クラスタ名: lab-cluster-31

- vSphere Zone 名: zone-1

3. ストレージ

Supervisor Control Plane VM のデータストア配置を指定するための仮想マシン ストレージ ポリシーを選択して、「次へ」をクリックします。

- 制御プレーン ストレージ ポリシー: vwt-nfs-policy

- 短期ディスク ストレージ ポリシー: vwt-nfs-policy

- イメージ キャッシュ ストレージ ポリシー: vwt-nfs-policy

ちなみに、それぞれ下記の用途で利用されます。

- 制御プレーン ノード → Supervisor Control Plane VM の VMDK を配置するデータストア

- 短期ディスク → vSphere Pod で利用するデータストア

- イメージ キャッシュ → コンテナ イメージのキャッシュ

4. 管理ネットワーク

Supervisor Control Plane VM(3台)の管理ネットワークを設定して、「次へ」をクリックします。このラボでは、下記のように設定しています。

- ネットワーク モード: 静的

- ネットワーク: dvpg-mgmt

- 開始 IP アドレス: 192.168.10.34(5つの IP アドレスが予約されるので ~ .38)

- サブネット マスク: 255.255.255.0

- ゲートウェイ: 192.168.10.1

- DNS サーバ: 192.168.1.101, 192.168.1.102

- DNS 検索ドメイン: go-lab.jp

- NTP サーバ: 192.168.1.101, 192.168.1.102

ここで指定する「開始 IP アドレス」は、Supervisor Control Plane VM に付与される IP アドレスで、開始 IP アドレスから 5つが採番されます。IP アドレスの割り当ては、かならずしも仮想マシン名末尾の番号「(1) ~」とは一致せず、デプロイ処理が完了した順に割り当てられるようです。

- Supervisor Control Plane VM の Floating IP アドレス。今回は .34

- Supervisor Control Plane VM #1。今回は .35

- Supervisor Control Plane VM #2。今回は .36

- Supervisor Control Plane VM #3。今回は .37

- アップグレード時の予約。今回は .38

5. ワークロード ネットワーク

スーパーバイザーの Kubernetes クラスタとしてのネットワーク設定です。このラボでは、下記のパラメータを入力して「次へ」をクリックします。

- vSphere Distributed Switch: DSwitch-31

- DNS サーバ: 192.168.1.101,192.168.1.102

- Edge クラスタ: edge-cluster-31

- Tier-0 ゲートウェイ: t0-gw-31

- NAT モード: 有効 ※デフォルトのまま

- サブネット プリフィックス: /28 ※デフォルトのまま

- 名前空間ネットワーク: 10.244.0.0/20 ※デフォルトのまま

- 入力方向 CIDR: 192.168.131.32/27

- 出力方向 CIDR: 192.168.131.64/27

ちなみに、ここで入力するアドレスは下記のように利用されます。

- 名前空間ネットワーク

- Supervisor Control Plane VM、vSphere Pod、TKGS クラスタ ノード仮想マシンの接続されるネットワークのアドレスです。

- 自動作成される NSX オーバーレイ セグメントに、レンジから「サブネット プレフィックス」単位(今回は /28)でネットワークが払い出されます。

- サービス CIDR

- Kubernetes クラスタ内部通信で使用される、ClusterIP のアドレス採番で使用されるレンジです。

- NSX LB / NSX ALB ではなく、NSX DLB(分散ロード バランサー)で、VIP が提供されます。

- 入力方向 CIDR

- Tier-0 ゲートウェイの外部インターフェイス(Edge のアップリンク)と同セグメントから、/27 以上のレンジを指定します。

- このレンジから、NSX LB または NSX ALB による VIP が払い出されます。

- この CIDR の1番目の IP アドレスは、CSI Controller の VIP(192.168.131.33)になります。

- この CIDR の2番目の IP アドレスは、Kube API Server VIP(192.168.131.34)になります。kubectl のダウンロード ページもこのアドレスです。

- 出力方向 CIDR

- スーパーバイザーで展開される Pod(コンテナ)などから外部にアクセスするための SNAT アドレスです。

- NSX Tier-1 ゲートウェイに、SNAT アドレスとして設定されます。

- Tier-0 ゲートウェイの外部インターフェイス(NSX Edge のアップリンク)と同セグメントから、/27 以上のレンジを指定します。

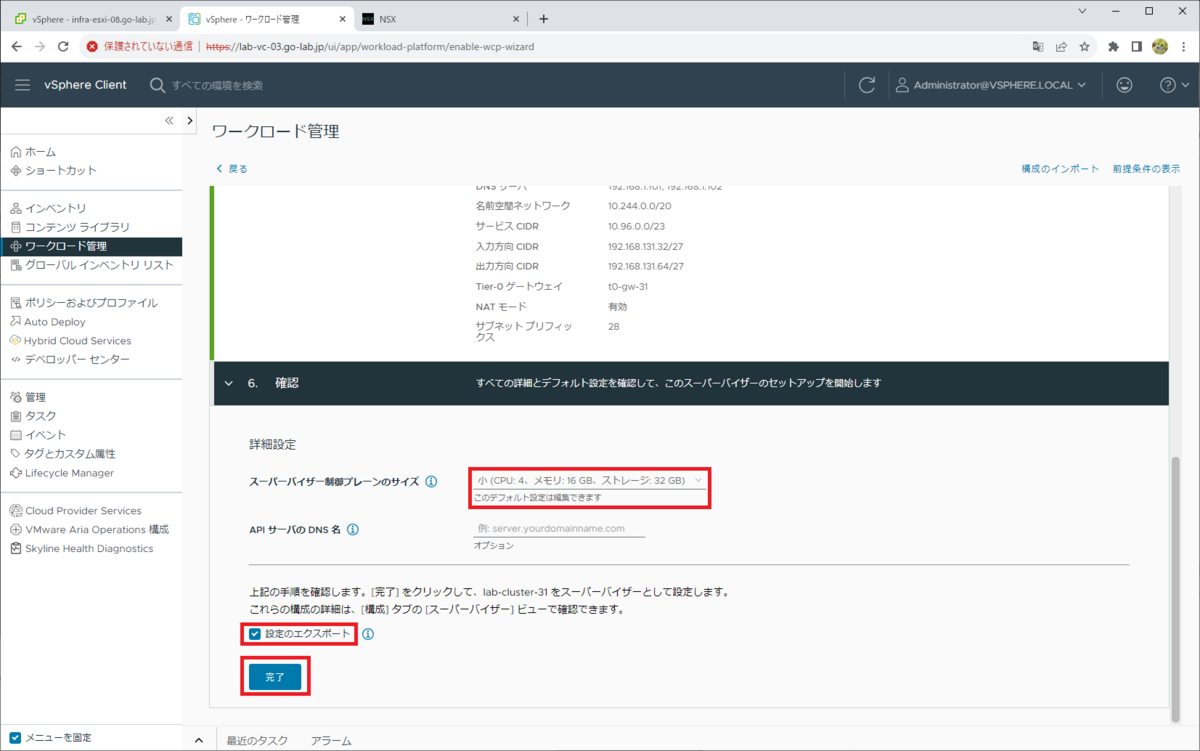

6. 確認

画面のタイトルは「6. 確認」となっていますが、Supervisor Control Plane VM のサイズなどを指定します。

- スーパーバイザー制御プレーンのサイズ: 小(4 vCPU、16GB RAM、32GB ストレージ)

- API サーバの DNS 名: 空欄のまま

- 設定のエクスポート: ON

そして「完了」をクリックすると、ワークロード管理を有効化する処理が開始します。

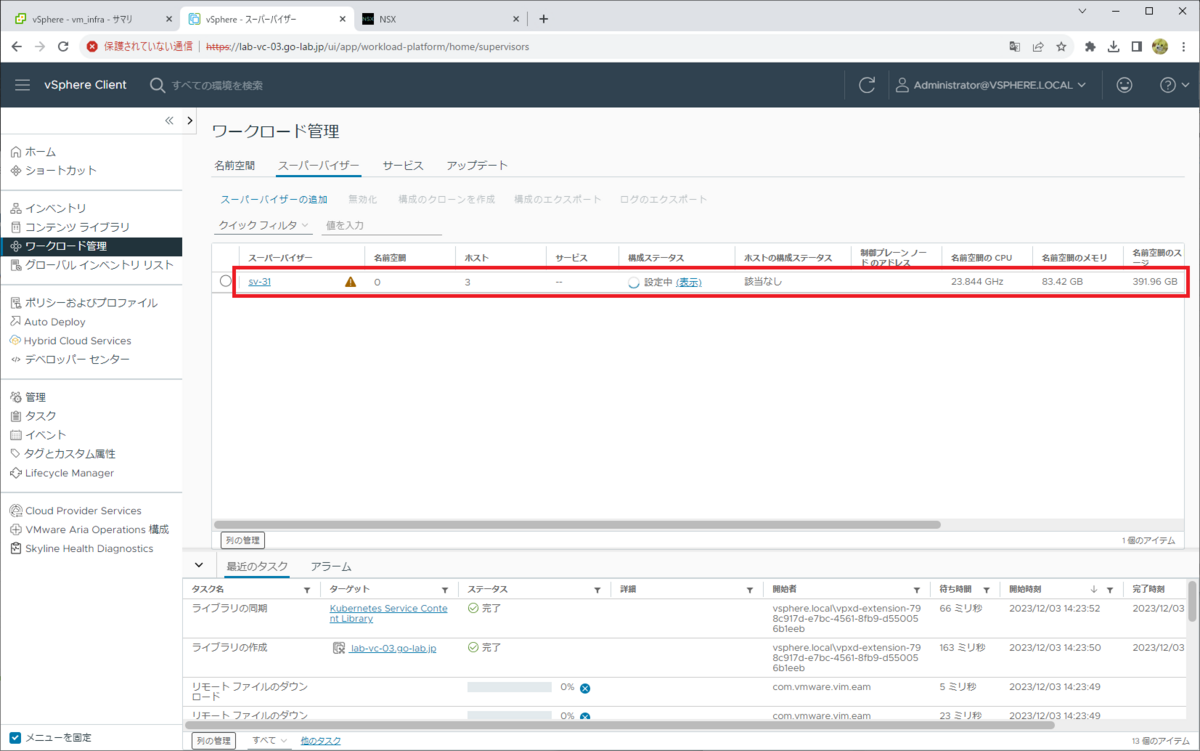

しばらく待ちます。

開始直後にタスク情報などを確認すると、いくつかエラー(リモートファイルのダウンロードでの 404 エラーなど)が表示されますが、自動的に再実行されて解消されるものもあるため、ひとまず無視します。

有効化処理がうまくいかない場合は、vCenter Server に root ユーザでログインして、まず下記のログを確認してみるとよいと思います。

- ログファイル: /var/log/vmware/wcp/wcpsvc.log

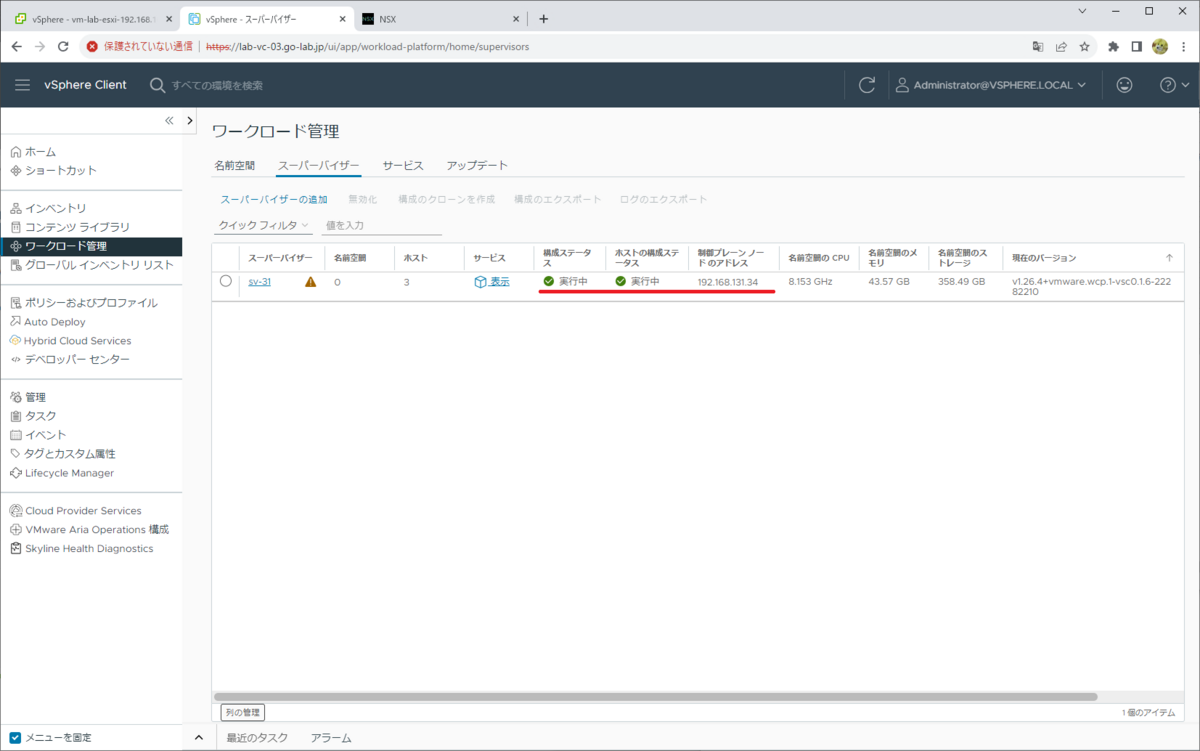

処理が完了すると、「構成ステータス」が「実行中」になります。

「制御プレーン ノードの IP アドレス」は、セットアップ処理中はまず「管理ネットワーク」の「開始 IP アドレス」で指定したアドレスになりますが、最終的に「入力方向 CIDR」で指定したレンジの IP アドレスに変更されます。

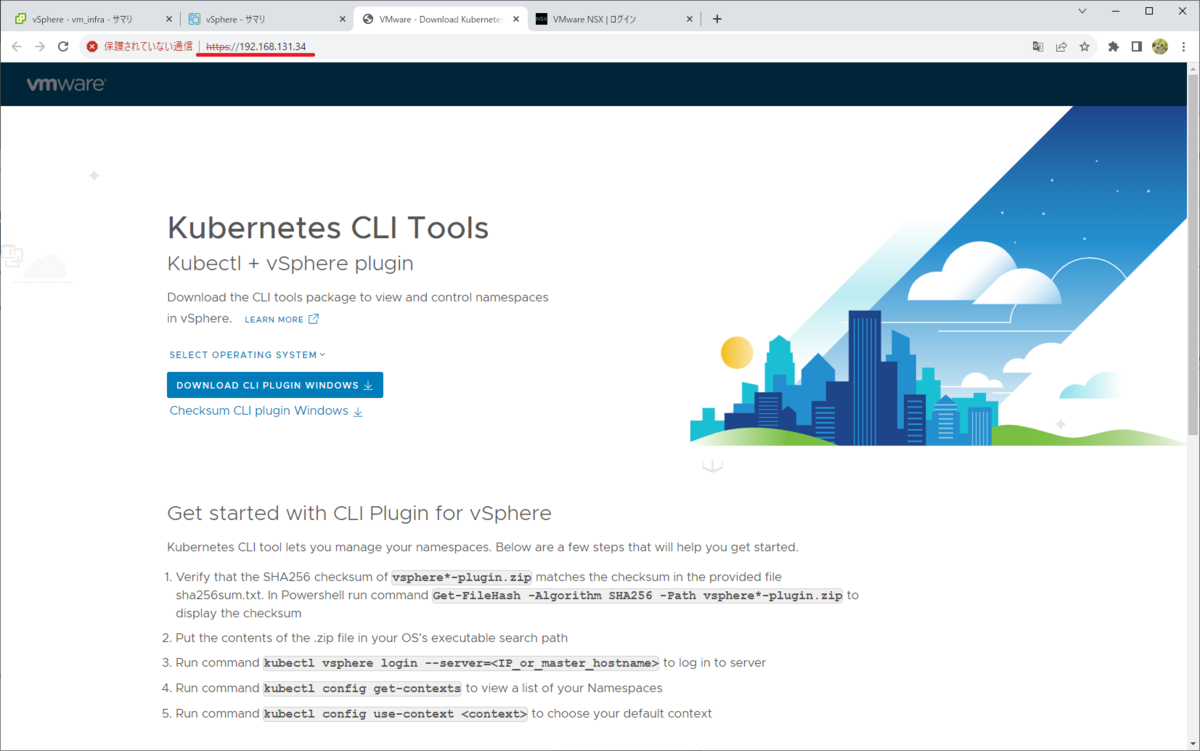

制御プレーン ノードの IP アドレスに Web ブラウザでアクセスして、証明書エラーを無視して進むと、Kubernetes CLI Tools のダウンロード ページが表示されます。

このページにアクセスできない場合は、ワークロード管理の有効化が成功していても、物理ネットワークや NSX オーバーレイ ネットワークなどの設定が不足していたり、構成がうまくできていない可能性があります。

ワークロード管理が有効化されたクラスタの様子

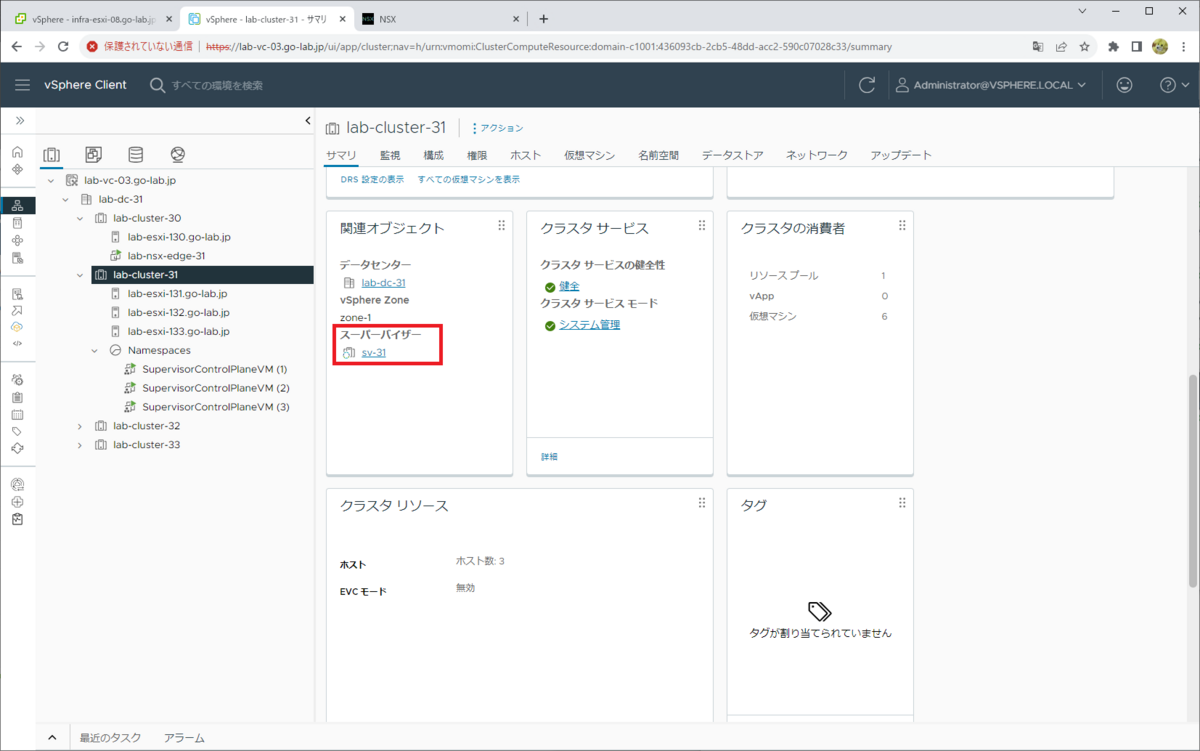

ワークロード管理が有効化され、スーパーバイザーが組み込まれたクラスタには、「Namespaces」リソースプールが作成され、3台の Supervisor Control Plane VM が展開されます。ちなみに、ESXi ホストが 4台以上あるクラスタでも 3台です。

クラスタの「サマリ」タブには、スーパーバイザーへのリンクが表示されます。

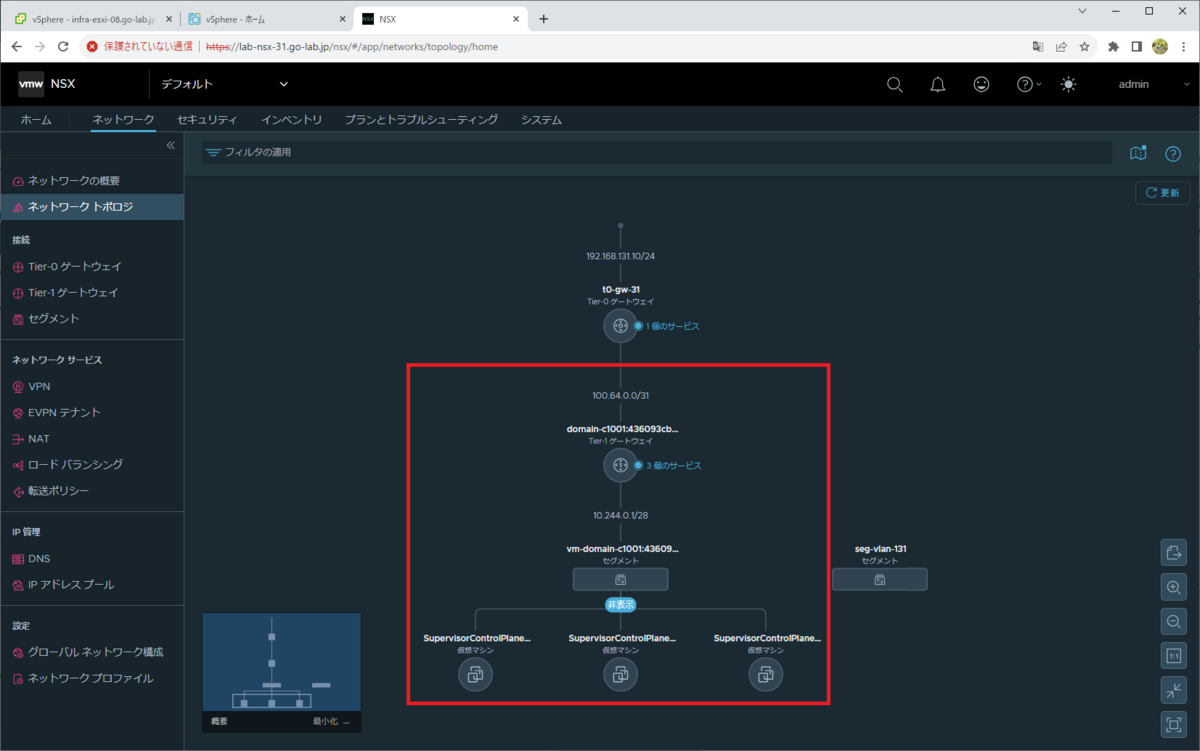

ちなみに NSX によるネットワークは、事前作成した Tier-0 ゲートウェイ(t0-gw-31)より下の部分に、下記のようなトポロジが自動作成されます。

つづく。